アナログインメモリ計算の新たな夜明け:物理特性を味方につける学習手法

近年、AI(人工知能)の進化は目覚ましいものがありますが、その一方で、AIの高度な計算には莫大な電力が必要となるという課題があります。この課題を解決する次世代の技術として注目されているのが、「アナログインメモリ計算」です。これは、AIの計算をメモリの中で直接行うことで、電力消費を大幅に抑えることができる革新的なハードウェア技術です。

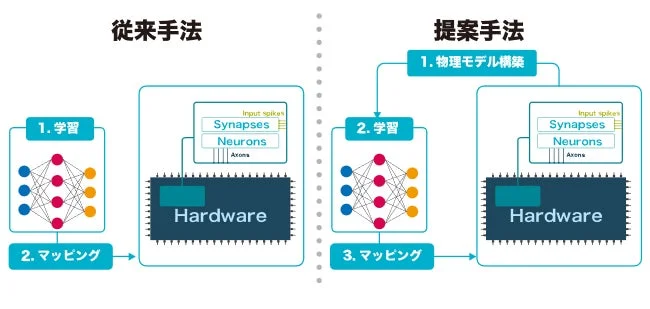

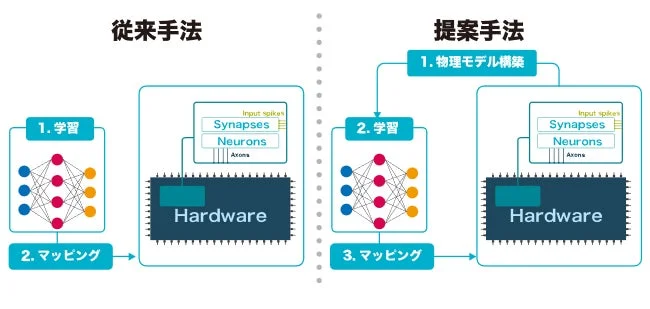

しかし、このアナログインメモリ計算を効率的に動作させるためには、アナログ回路特有の複雑な性質(「非理想的特性」と呼ばれます)をうまく扱う必要がありました。これまでの学習方法では、これらの複雑な特性をうまく取り込むことが難しく、実用的なAIモデルの学習には高いハードルがありました。

新しい学習手法「ODEベース学習」と「DSTD」の登場

千葉工業大学、京都大学、九州工業大学、日本電気株式会社、東京大学の研究者からなるチームは、この課題を解決する新しい学習手法の開発に成功しました。

この手法の鍵は、アナログハードウェアの動きを「常微分方程式(ODE)」という数学的な式で表し、それを直接AIの学習に組み込む点にあります。これにより、これまでは学習アルゴリズムに含めることができなかった、アナログ回路ならではの複雑な非線形特性を学習プロセスに取り込むことが可能になりました。

しかし、この物理モデルを直接学習させる方法は、非常に計算量が多く、大規模なAIモデルには適用が難しいという課題がありました。そこで研究チームは、「differentiable spike-time discretization (DSTD)」という新しい学習手法を開発。これにより、学習の効率をなんと約1000倍も高めることに成功しました。その結果、実用的な規模とされる8層の畳み込みニューラルネットワークの学習も可能になりました。

「非理想的」特性が性能向上に?

この研究で特に注目すべきは、これまでAIの学習性能を低下させると考えられていたアナログ回路の「非理想的特性」が、むしろ学習性能を高める場合があることが確認された点です。これは、アナログ回路の設計における従来の常識を大きく覆す可能性を秘めています。

研究チームは、この新しい学習手法の有効性を実際の回路設計とそのシミュレーションでも検証しており、実用化に向けた大きな一歩を踏み出しました。

今後の展望

この成果は、超低消費電力で動作する次世代AIハードウェア「アナログインメモリ計算回路」の実現を大きく加速させるものです。これまで避けられてきたアナログ回路の複雑な特性を積極的に活用することで、より高性能で省エネなAIシステムが開発されることが期待されます。

この研究成果は、2025年8月18日に国際学術雑誌「Advanced Intelligent Systems」で公開されました。

詳細については、千葉工業大学のプレスリリースをご参照ください。

https://chibatech.jp/news/imolkd0000004c3f-att/pressanalog.pdf