TheDress画像の色の見え方には個人差があることが、人工知能(AI)の計算モデルを使って解明されました。

#TheDress画像とは?

約10年前、SNS上で一枚のドレスの写真が大きな話題となりました。それが「#TheDress」画像です。このドレスの色が、ある人には「白地に金の飾り(白/金)」に見え、また別の人には「青地に黒の飾り(青/黒)」に見えるという、不思議な現象が起きたのです。

図1:#TheDress画像。見る人によって白/金または青/黒に見える。

この見え方の違いは、なぜ起こるのか?その理由はこれまで詳しく分かっていませんでした。今回、埼玉大学と近畿大学の研究チームが、AIの基礎となる「DNN(深層学習)」という計算モデルを使って、この個人差の謎に迫りました。

錯視の個人差は「ブルー・バイアス」が原因

研究の結果、#TheDress画像の色の見え方の個人差は、「ブルー・バイアス」という、私たちが日常生活の中で無意識に身につける色認識の傾向に依存していることが分かりました。

ブルー・バイアスとは、例えば晴れた日の日陰にある白い物体が、青空の光を反射して少し青みがかって見えることがあります。しかし、私たちは経験的にそれが白い物体だと知っているので、この青みがかった光を「白」として認識する傾向があります。この傾向が「ブルー・バイアス」と呼ばれ、人によってその強さに個人差があると考えられています。

研究チームは、このブルー・バイアスが強く働く人ほど、#TheDress画像を「白/金」と解釈するのではないか、と予想しました。

AIモデル「pix2pix」を使った実験

この仮説を検証するために、研究チームは「pix2pix」という種類のDNN(深層学習)モデルを用いました。これは、入力された画像を、人間が色名を答えるように19種類の基本色に変換して出力するよう学習させたAIモデルです。

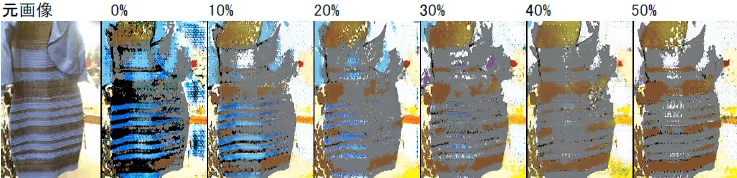

実験では、このAIモデルに「青空の下に白い被写体がある画像(ブルー・バイアス画像)」を含める割合を、0%から50%まで10段階に変えて学習させ、10種類のモデルを作りました。

その結果、ブルー・バイアス画像の学習比率が0%から50%まで増えるにつれて、#TheDress画像に対するAIの出力が段階的に変化し、最初は「青/黒」と認識していたものが、徐々に「白/金」へと変化していくことが確認されました。

図2:ブルー・バイアス画像の学習比率を変えた時のDNNモデルの出力変化。0%では青/黒に見えるが、50%では白/金に見える。

注目すべきは、この学習の際には#TheDress画像自体は一切使われていない点です。AIがブルー・バイアスに関わる様々な情景を学習した結果、自動的に#TheDress画像の見え方にも個人差のような変化が生まれたのです。このことは、私たちが青空の下で白い物体を見る機会など、日常の経験によってブルー・バイアスの個人差が生まれ、それが#TheDress画像の色の感じ方の違いにつながる可能性を示しています。

今後の展望

AIのような計算モデルを使う最大のメリットは、人間では難しいような極端な環境での実験や、モデルの内部を詳しく「解剖」するような研究ができる点にあります。今回の研究では、極端な環境での学習を行いましたが、今後はさらにAIモデルの内部を詳しく分析し、ブルー・バイアスによって情報がどのように処理されているかを解読することを目指します。

これにより、人間の脳がブルー・バイアスによってどのように色を認識しているかについて、新たな手がかりが得られると期待されています。将来的には、この手がかりをもとに、脳の活動を計測する技術などを使い、脳内での色情報の処理メカニズムをさらに深く解明していく予定です。

研究の詳細

この研究成果は、知覚科学研究に関するオンラインの学術誌「i-Perception」に2025年11月5日に掲載されました。

-

掲載誌: i-Perception

-

題名: Can DNN models simulate appearance variations of #TheDress?

-

著者: 栗木一郎・斎藤輝・大久保類・清川宏暁(埼玉大学)・篠崎隆志(近畿大学)

本研究は、科学研究費補助金(科研費)「DNNの解剖による#TheDressの脳内メカニズムの解明」(課題番号:21K19777、研究代表者:栗木一郎)の補助を受けて行われました。

関連リンク

-

近畿大学情報学部 情報学科 准教授 篠崎隆志: https://www.kindai.ac.jp/meikan/2769-shinozaki-takashi.html

-

近畿大学情報学部: https://www.kindai.ac.jp/informatics/