GMO GPUクラウド、次世代AIインフラ「NVIDIA HGX B300」を国内最速クラスで提供開始

GMOインターネットが提供する高性能GPUクラウドサービス「GMO GPUクラウド」は、2025年12月16日より、最新の「NVIDIA Blackwell Ultra GPU」を搭載した「NVIDIA HGX B300 AI インフラストラクチャ」(以下、HGX B300)のクラウドサービスを国内最速クラスで提供開始しました。この新しいサービスは、AI開発や研究を大きく前進させる可能性を秘めています。

AIの「頭脳」がさらにパワーアップ!NVIDIA Blackwell Ultra GPUとは

AI技術は日々進化しており、特に大規模なAIモデル(大規模言語モデル、LLMなど)を動かすためには、非常に高い計算能力が求められます。HGX B300に搭載されている「NVIDIA Blackwell Ultra GPU」は、AIの計算処理を担う「頭脳」とも言える部分で、これまでよりも格段に性能が向上しています。

このGPUの大きな特徴は以下の通りです。

-

処理能力の向上: 新たな計算方法(FP4演算精度)に対応し、AIの学習や推論(AIが答えを導き出す処理)がより高速になりました。特に、前世代のGPUと比較して、AIの学習性能は最大4倍、推論性能は最大11倍にまで向上しています。

-

大容量メモリ: GPUに搭載されるメモリ(GPUメモリ)の容量が288GBと大幅に増え、より複雑で大きなAIモデルも効率的に処理できるようになりました。総GPUメモリは2.3TBに達します。

国内最速クラスの「ベアメタル構成」で最大限の性能を引き出す

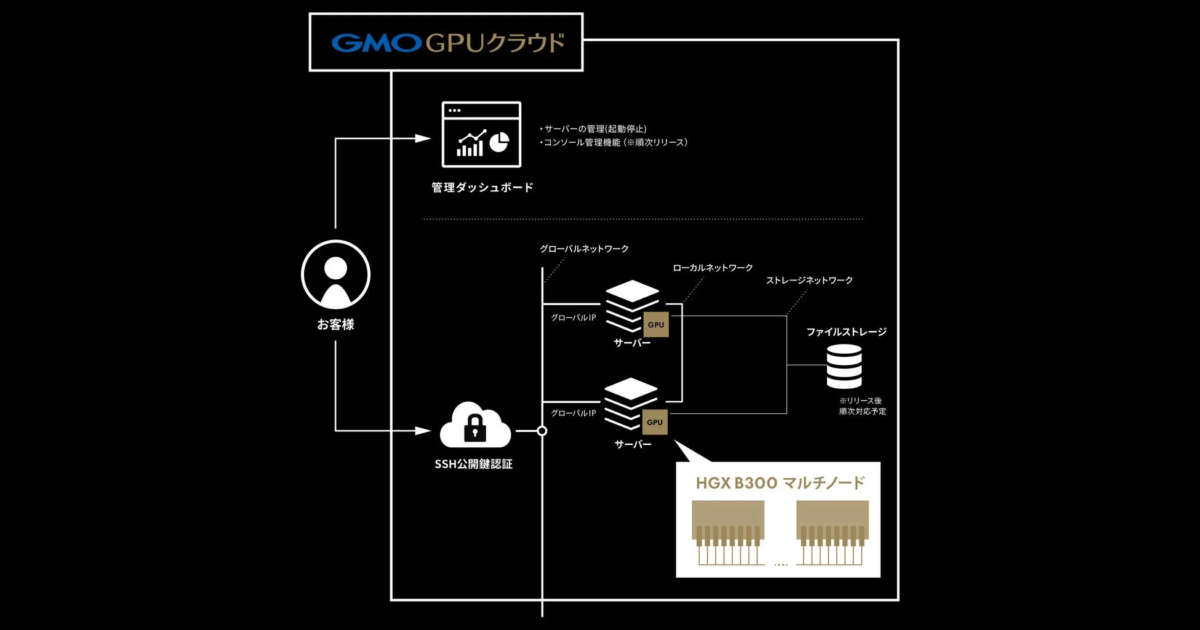

「GMO GPUクラウド」の「ベアメタルプラン」は、サーバー1台をまるごとお客様が専有する形で提供されます。これにより、仮想化の層を介さずにGPUに直接アクセスできるため、HGX B300の持つ計算性能を最大限に引き出すことが可能です。

AI推論処理に特化した演算能力を活かし、大規模言語モデルの高速推論や、エージェント型AI開発など、最先端のAIワークロードに最適な環境を提供します。

また、このプランはUbuntu OSが初期設定済みで提供され、ネットワーク設定も完了しているため、利用者はAI開発環境の構築にかかる手間を減らし、すぐに開発に取り掛かることができます。

超高速ネットワークでAI開発をサポート

HGX B300 AIインフラストラクチャは、8基のNVIDIA ConnectX-8 SuperNICsとNVIDIA Spectrum-X Ethernetスイッチによって、合計6,400Gbpsという超高速通信を実現しています。これにより、大規模なAI学習を行う際のデータ転送が非常に速くなり、複数のサーバーを使った分散学習環境でも安定した高い性能を発揮します。

-

NVIDIA Blackwellアーキテクチャについて: https://www.nvidia.com/ja-jp/data-center/technologies/blackwell-architecture/

-

NVIDIA ConnectX-8 SuperNICsについて: https://www.nvidia.com/ja-jp/networking/products/ethernet/supernic/

-

NVIDIA Spectrum-X Ethernetスイッチについて: https://www.nvidia.com/ja-jp/networking/spectrumx/

AI開発の未来を支えるGMO GPUクラウド

GMOインターネットの伊藤 正 社長執行役員は、「NVIDIA B300を国内最速で提供することは、日本発のAIイノベーションを次のステージへ加速させる取り組みにつながると確信している」とコメントしています。

また、エヌビディア 日本代表 兼 米国本社副社長の大崎 真孝氏も、「高効率な学習と高速推論を可能にするNVIDIA HGX B300を搭載した『GMO GPUクラウド』を国内で提供されることは、日本のAIインフラストラクチャをリードする大きな一歩と言える」と述べています。

「GMO GPUクラウド」は、今後も最新のAI計算基盤と柔軟なクラウド環境を提供し、日本のAI産業の発展に貢献していく方針です。生成AI分野に取り組む企業や研究機関にとって、開発期間の短縮とコスト削減に役立つ重要なインフラとなるでしょう。

GMO GPUクラウドの詳細については、以下のURLをご覧ください。

https://gpucloud.gmo/