AI時代の電力消費を抑える!水冷GPUサーバーの効率運用に成功

AI(人工知能)やHPC(高性能計算)が私たちの生活やビジネスにますます深く関わるようになり、これを支える高性能なコンピューター「GPUサーバー」の需要が急増しています。特に、たくさんの計算を素早くこなすGPUサーバーは、熱をたくさん出すため、効率的に冷やす技術がとても重要になります。

日本ではまだ「空冷式」という空気で冷やすタイプのデータセンターが主流ですが、海外では水を使って効率よく冷やす「水冷式」のGPUサーバーが増えています。この状況を受け、NTTPCコミュニケーションズ株式会社、株式会社ゲットワークス、株式会社フィックスターズの3社は、水冷GPUサーバーを国内で効率的に運用するための新しい実験(PoC:概念実証)に取り組みました。

持ち運びできるデータセンターで高い電力効率を達成

今回の実験では、持ち運び可能な「コンテナ型データセンター」の中に水冷GPUサーバーを設置し、データセンター全体、GPUサーバー、そしてソフトウェアの連携を細かく調整しました。その結果、データセンターの電力のムダを測る指標である「pPUE(ピーピーユーイー)」で、1.114という非常に優れた数値を記録しました。この数値は、大規模なデータセンターでも達成が難しいとされる範囲で、水冷GPUサーバーが商用利用でどれだけ役立つかをはっきりと示しています。

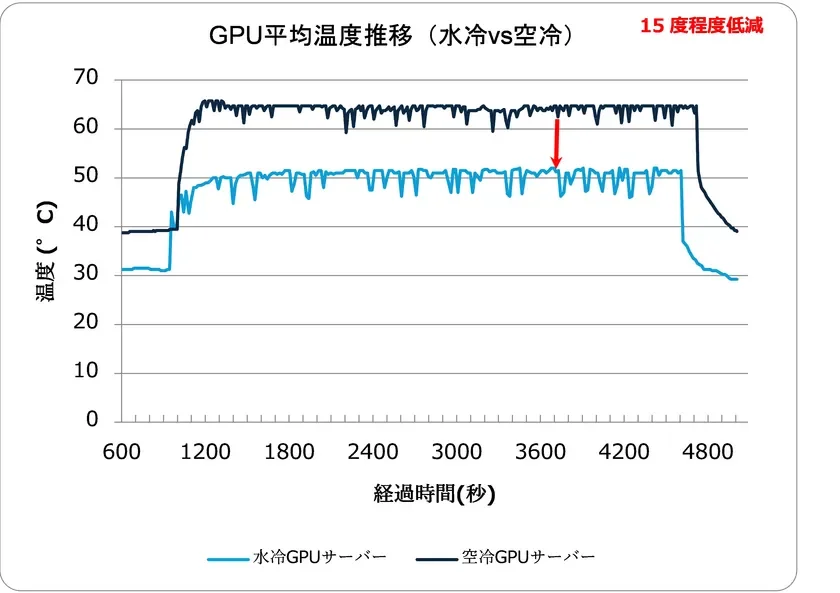

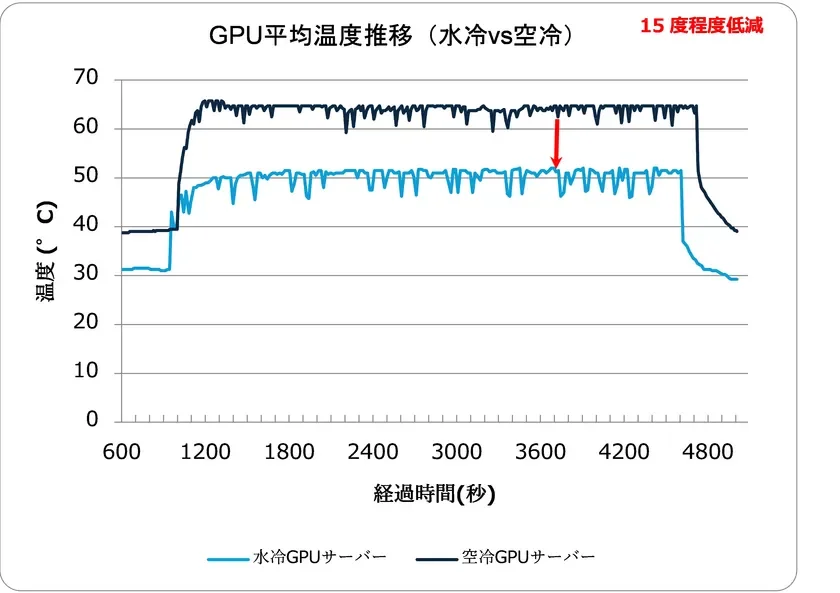

実験では、水冷GPUサーバーが空冷GPUサーバーに比べて、GPUの平均温度を約15度も低く保てることを確認しました。これにより、GPUが安定して最高の性能を発揮できるようになります。

さらに、サーバーの負荷や温度をリアルタイムで監視し、冷却システムを最適にコントロールするシステムも構築。この統合的な管理によって、運用効率を最大限に高めることができました。

このPoCの詳しいレポートは、以下のリンクからご覧いただけます。

各社が協力して実現

今回の成功は、3社の専門知識と技術が結集した結果です。

-

NTTPCコミュニケーションズ株式会社:大規模なGPUクラスターを運用してきた経験から、ハードウェア技術の面で検証を主導しました。

-

株式会社ゲットワークス:コンテナ型データセンターの提供と、最適なサーバー稼働環境の構築を担当しました。

-

株式会社フィックスターズ:水冷GPUサーバーと冷却設備を提供し、コンテナ内の環境やハードウェア、ソフトウェアをまとめて管理するモニタリングツールを開発しました。

これからの展望

高性能なAIを動かすGPUサーバーの需要は、これからもどんどん増えていくでしょう。これに伴い、水冷GPUサーバーの必要性も高まると考えられます。

今回の成功を足がかりに、3社は引き続き協力し、日本国内でコンテナ型データセンターを使った水冷GPUサーバーがさらに広く利用されるよう、取り組んでいくとのことです。AI技術の進化を支えるインフラの発展に期待が寄せられます。